| 失效链接处理 |

|

Spark on Yarn模式部署 PDF 下载

本站整理下载:

相关截图:

主要内容:

部署步骤:

一、修改主机名,添加主机名到IP地址映射。

二、配置免密码登录

三、安装并配置JDK8

四、配置Hadoop

五、配置Spark

一、 修改主机名,添加主机名到IP地址映射

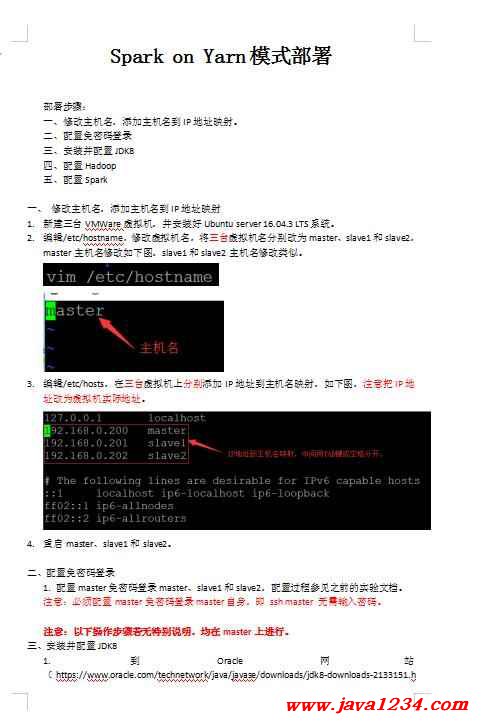

1.新建三台VMWare虚拟机,并安装好Ubuntu server 16.04.3 LTS系统。

2.编辑/etc/hostname,修改虚拟机名,将三台虚拟机名分别改为master、slave1和slave2,master主机名修改如下图,slave1和slave2主机名修改类似。

3.编辑/etc/hosts,在三台虚拟机上分别添加IP地址到主机名映射,如下图,注意把IP地址改为虚拟机实际地址。

4.重启master、slave1和slave2。

二、配置免密码登录

1. 配置master免密码登录master、slave1和slave2,配置过程参见之前的实验文档。

注意:必须配置master免密码登录master自身,即 ssh master 无需输入密码。

注意:以下操作步骤若无特别说明,均在master上进行。

三、安装并配置JDK8

1. 到Oracle网站(https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html)下载JDK8(注意下载jdk-8u261-linux-x64.tar.gz版本),把windows中下载的jdk8通过PSCP传到master上,如下图,或者在master上通过命令:wget 下载连接 直接下载。

2. 将jdk8复制到/usr/目录,并解压,操作命令如下图。

3. 编辑/etc/profile,在尾部加入Java环境变量,如下图:

export JAVA_HOME=/usr/jdk1.8.0_181 (注意:改为JDK8实际位置)

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

4. 执行命令:source /etc/profile,使修改后的profile文件立即生效。

5. 验证jdk8,输入:java –version,有下图提示信息,说明jdk8配置成功。

四、配置Hadoop

1. 下载Hadoop3.1.4的binary版本(下载地址:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.4/hadoop-3.1.4.tar.gz)和spark-3.0.1-bin-hadoop2.7.tgz(下载地址:https://archive.apache.org/dist/spark/spark-3.0.1/spark-3.0.1-bin-hadoop2.7.tgz),将下载的hadoop和spark通过PSCP上传到master中,或者在master上直接通过wget下载。

2. 进入/usr,新建目录spark-on-yarn,命令:mkdir spark-on-yarn,将hadoop和spark复制到spark-on-yarn目录下,并解压。

3. 编辑profile :vim /etc/profile,加入hadoop home环境变量信息,如下图,然后执行: source /etc/profile,使修改后profile立即生效。

export HADOOP_HOME=/usr/spark-on-yarn/hadoop-3.1.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

4. 进入hadoop配置文件目录(Hadoop解压目录下的etc/hadoop),配置hadoop,命令:cd /usr/spark-on-yarn/hadoop-3.1.1/etc/hadoop,需要配置7个文件。

5. 编辑hadoop-env.sh :,在其中加入JAVA_HOME和权限信息,如下图。

6. 编辑yarn-env.sh :,在其中加入JAVA_HOME信息,如下图。

7. 编辑workers : ,在其中加入slave1和slave2,如下图。

8. 编辑core-site.xml : ,在其中加入下图所示配置信息,参见示例文件。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号