| 失效链接处理 |

|

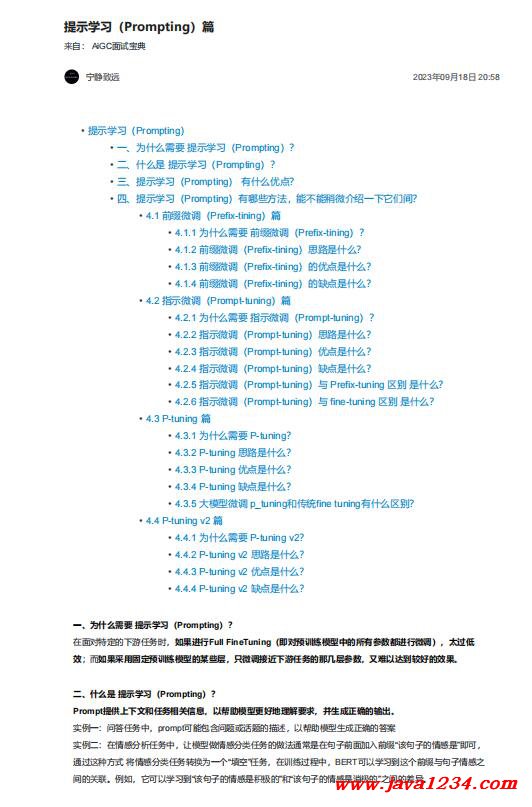

提示学习(Prompting)篇 PDF 下载

相关截图:

主要内容: 一、为什么需要 提示学习(Prompting)?

在面对特定的下游任务时,如果进行Full FineTuning(即对预训练模型中的所有参数都进行微调),太过低

效;而如果采用固定预训练模型的某些层,只微调接近下游任务的那几层参数,又难以达到较好的效果。

二、什么是 提示学习(Prompting)?

Prompt提供上下文和任务相关信息,以帮助模型更好地理解要求,并生成正确的输出。

实例一:问答任务中,prompt可能包含问题或话题的描述,以帮助模型生成正确的答案

实例二:在情感分析任务中,让模型做情感分类任务的做法通常是在句子前面加入前缀“该句子的情感是”即可,

通过这种方式 将情感分类任务转换为一个“填空”任务,在训练过程中,BERT可以学习到这个前缀与句子情感之

间的关联。例如,它可以学习到“该句子的情感是积极的”和“该句子的情感是消极的”之间的差异。

三、提示学习(Prompting) 有什么优点?

提示学习(Prompting)旨在通过最小化微调参数的数量和计算复杂度,来提高预训练模型在新任务上的性能,

从而缓解大型预训练模型的训练成本。这样一来,即使计算资源受限,也可以利用预训练模型的知识来迅速适应

新任务,实现高效的迁移学习。

四、提示学习(Prompting)有哪些方法,能不能稍微介绍一下它们间?

4.1 前缀微调(Prefix-tining)篇

4.1.1 为什么需要 前缀微调(Prefix-tining)?

1. 人工设计离散的 Prompts 缺点:

a. Prompts 的变化对模型最终的性能特别敏感,加一个词、少一个词或者变动位置都会造成比较大的

变化

2. 自动化搜索离散的 Prompts 缺点:

a. 成本也比较高

3. 离散化的token搜索出来的结果可能并不是最优的;

4. 传统的微调范式利用预训练模型去对不同的下游任务进行微调,对每个任务都要保存一份微调后的模型权

重,一方面微调整个模型耗时长;另一方面也会占很多存储空间

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号