| 失效链接处理 |

|

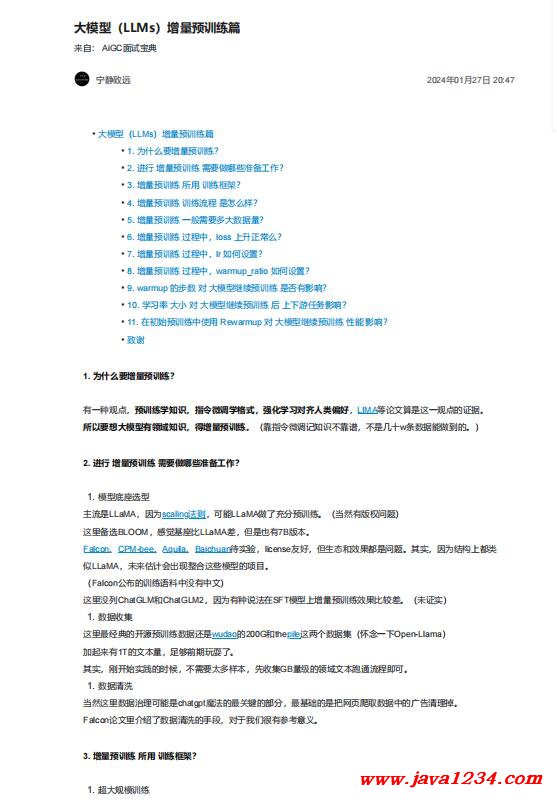

大模型(LLMs)增量预训练篇 PDF 下载

相关截图:

主要内容:

1. 为什么要增量预训练?

有一种观点,预训练学知识,指令微调学格式,强化学习对齐人类偏好,LIMA等论文算是这一观点的证据。

所以要想大模型有领域知识,得增量预训练。(靠指令微调记知识不靠谱,不是几十w条数据能做到的。)

2. 进行 增量预训练 需要做哪些准备工作?

1. 模型底座选型

主流是LLaMA,因为scaling法则,可能LLaMA做了充分预训练。(当然有版权问题)

这里备选BLOOM,感觉基座比LLaMA差,但是也有7B版本。

Falcon、CPM-bee、Aquila、Baichuan待实验,license友好,但生态和效果都是问题。其实,因为结构上都类

似LLaMA,未来估计会出现整合这些模型的项目。

(Falcon公布的训练语料中没有中文)

这里没列ChatGLM和ChatGLM2,因为有种说法在SFT模型上增量预训练效果比较差。(未证实)

这里最经典的开源预训练数据还是wudao的200G和thepile这两个数据集(怀念一下Open-Llama)

加起来有1T的文本量,足够前期玩耍了。

其实,刚开始实践的时候,不需要太多样本,先收集GB量级的领域文本跑通流程即可。

当然这里数据治理可能是chatgpt魔法的最关键的部分,最基础的是把网页爬取数据中的广告清理掉。

Falcon论文里介绍了数据清洗的手段,对于我们很有参考意义。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号